cours_processus_Sa3di

-

Upload

adnane-yahyaoui -

Category

Documents

-

view

143 -

download

0

Transcript of cours_processus_Sa3di

5/14/2018 cours_processus_Sa3di - slidepdf.com

http://slidepdf.com/reader/full/coursprocessussa3di 1/37

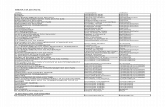

Table des matières

I Rappels de probabilités 4

I.1 Espace de probabilité . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 4

I.2 Variable aléatoire . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 5

I.2.1 Loi d’une variable aléatoire . . . . . . . . . . . . . . . . . . . . . 5

I.2.2 Espérance d’une variable aléatoire . . . . . . . . . . . . . . . . . . 6

I.2.3 Variance et covariance . . . . . . . . . . . . . . . . . . . . . . . . 7

I.3 Indépendance . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 7

I.3.1 Indépendance d’évenements . . . . . . . . . . . . . . . . . . . . . 7

I.3.2 Indépendance de tribus . . . . . . . . . . . . . . . . . . . . . . . . 8

I.3.3 Indépendance de variables aléatoires . . . . . . . . . . . . . . . . . 8

I.4 Espérance conditionnelle . . . . . . . . . . . . . . . . . . . . . . . . . . . 8

I.4.1 Conditionnement par rapport à un événement . . . . . . . . . . . . 8

I.4.2 Conditionnement par rapport à une variable aléatoire discrète Y . . 9

I.4.3 Conditionnement par rapport à une v.a. Y continue . . . . . . . . . 9

I.4.4 Conditionnement par rapport à une tribu G . . . . . . . . . . . . . 9

I.5 Convergences de suites de variables aléatoires . . . . . . . . . . . . . . . . 10

II Généralités 12

II.1 Processus stochastique . . . . . . . . . . . . . . . . . . . . . . . . . . . . 12

II.2 Classification de Processus stochastiques . . . . . . . . . . . . . . . . . . . 13

1

5/14/2018 cours_processus_Sa3di - slidepdf.com

http://slidepdf.com/reader/full/coursprocessussa3di 2/37

II.2.1 Processus à accroissements indépendants et stationnaires . . . . . . 13

II.2.2 Processus stationnaires . . . . . . . . . . . . . . . . . . . . . . . . 14

III Processus de Poisson 15

III.1 Processus ponctuels et fonction de comptage . . . . . . . . . . . . . . . . . 15

III.2 Processus de poisson . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 16

III.3 Les temps d’arrivées . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 17

III.4 Superposition de Processus de Poisson . . . . . . . . . . . . . . . . . . . . 18

III.5 Décomposition d’un processus de poisson . . . . . . . . . . . . . . . . . . 18

III.5.1 paradoxe de l’autobus . . . . . . . . . . . . . . . . . . . . . . . . 19

IV Chaînes de Markov 20

IV.1 Définition et propriétés . . . . . . . . . . . . . . . . . . . . . . . . . . . . 20

IV.2 Proprièté forte de Markov . . . . . . . . . . . . . . . . . . . . . . . . . . . 23

IV.2.1 Temps d’arrêt . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 23

IV.2.2 Propriété de Markov forte . . . . . . . . . . . . . . . . . . . . . . 24

IV.3 Classification des états . . . . . . . . . . . . . . . . . . . . . . . . . . . . 25

IV.3.1 Etat récurrent et état transitoire . . . . . . . . . . . . . . . . . . . . 25

IV.3.2 Classes . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 26

IV.3.3 Période . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 27

IV.4 Comportement asymptotique . . . . . . . . . . . . . . . . . . . . . . . . . 27

IV.4.1 Cas récurrent irréductible . . . . . . . . . . . . . . . . . . . . . . . 27

IV.4.2 Chaînes apériodiques . . . . . . . . . . . . . . . . . . . . . . . . . 29

V Processus Markovien de saut 30

V.1 Définition et Propriétés . . . . . . . . . . . . . . . . . . . . . . . . . . . . 30

V.2 propriété de Markov forte . . . . . . . . . . . . . . . . . . . . . . . . . . . 32

V.2.1 Temps d’arrêt . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 32

2

5/14/2018 cours_processus_Sa3di - slidepdf.com

http://slidepdf.com/reader/full/coursprocessussa3di 3/37

V.3 Générateur infinitésimal . . . . . . . . . . . . . . . . . . . . . . . . . . . . 32

V.3.1 Temps passé dans un état . . . . . . . . . . . . . . . . . . . . . . . 32

V.3.2 Chaîne de Markov incluse . . . . . . . . . . . . . . . . . . . . . . 33V.3.3 Equations de Kolmogorov . . . . . . . . . . . . . . . . . . . . . . 34

V.4 Mesures invariantes et Théorèmes limites . . . . . . . . . . . . . . . . . . 35

V.4.1 Classification des états . . . . . . . . . . . . . . . . . . . . . . . . 35

V.4.2 Le cas irréductible récurrent . . . . . . . . . . . . . . . . . . . . . 35

V.4.3 Théorèmes limites . . . . . . . . . . . . . . . . . . . . . . . . . . 36

3

5/14/2018 cours_processus_Sa3di - slidepdf.com

http://slidepdf.com/reader/full/coursprocessussa3di 4/37

Chapitre I

Rappels de probabilités

I.1 Espace de probabilité

Un espace de probabilité est un triplet (Ω,F ,P ) où:

– Ω est l’ensemble de tout les résultats associés à une expérience.– F est une tribu sur Ω, i.e. F est un ensemble de sous ensemble de Ω, appelés événe-

ments, tel que:

(i) ∅ ∈ F et Ω ∈ F ,(ii) A

∈ F ⇒Ac

∈ F ,

(iii) Si An ∈ F pour n = 1,2,..., alors+∞n=1

An ∈ F

– P est une mesure de probabilité sur (Ω,F ), c’est-à-dire, P est une application de F dans [0,1] telle que:

(a) P (∅) = 0 et P (Ω) = 1,

(b) P (+∞n=1

An) =∞n=1

P (An), pour toute famille An,n ∈ N d’événements disjoints

deux à deux.

Les axiomes (i) et (ii) impliquent que+∞n=1

An ∈ F .

Les axiomes (a) et (b) entrainent, pour tous événements A et B,

– P (A) = 1 − P (Ac),– A ⊂ B ⇒ P (A) ≤ P (B),

4

5/14/2018 cours_processus_Sa3di - slidepdf.com

http://slidepdf.com/reader/full/coursprocessussa3di 5/37

CHAPITRE I RAPPELS

– P (A ∪ B) = P (A) + P (B) − P (A ∩ B).

Exemple: L’expérience consiste à lancer un dé. Alors

Ω = 1,2,3,4,5,6A = 1,3,5 est l’événement avoir un nombre impaire.Si le dé est équilibré, la mesure de probabilité sur (Ω,F = P (Ω)) est définie par P (i) =16

,∀i. Et donc P (A) = 12

.

I.2 Variable aléatoire

Définition I.2.1 Soit (Ω,

F ,P ) un espace de probabilité. Une variable aléatoire (v.a.) est

une application X : Ω → R telle que,

ω ∈ Ω : X (ω) ∈ B = X ∈ B ∈ F , ∀B ∈ B(R).

Proposition I.2.2 X est une v.a. si et seulement si ω ∈ Ω : X (ω) ≤ x ∈ F , ∀x ∈ R

Définition I.2.3 La tribu engendrée par une famille de v.a. X i,i ∈ I sur (Ω,F ,P ) est

définie par

σ(X i,i ∈ I ) = σ(X i ∈ B,i ∈ I,B ∈ B(R)) = σ(X i ≤ x,i ∈ I,x ∈ R).

I.2.1 Loi d’une variable aléatoire

Définition I.2.4 La loi d’une v.a. X est l’application µ : B(R) → [0,1] définie par

µ(B) = P (X ∈ B), B ∈ B(R).

Définition I.2.5 La fonction de répartition d’une v.a. X est l’application F : B(R) → [0,1]définie par

F (x) = P (X ≤ x) = µ(] − ∞,x]), x ∈ R

F vérifie les propriétés suivantes,

– limx→+∞

F (x) = 1,

– limx→−∞

F (x) = 0,

– F est croissante.

S. SAADI 5

5/14/2018 cours_processus_Sa3di - slidepdf.com

http://slidepdf.com/reader/full/coursprocessussa3di 6/37

CHAPITRE I RAPPELS

Variable aléatoire discrète:

Une v.a. X est discrète si elle prend ses valeurs dans un ensemble D dénombrable. Dans

ce cas on a,F (t) =

x∈D:x≤t

P (X = x), ∀t ∈ D

Nous avonsx∈D

P (X = x) = 1.

Exemple: Loi Binomiale B(n,p), n ≥ 1, p ∈ [0,1] telle que

P (X = k) = C pn pk(1 − p)n−k, 0 ≤ k ≤ n.

Variable aléatoire continue:

Une v.a. est continue si P (X = x) = 0 pour tout x. La fonction densité d’une v.a. continueest une fonction f telle que,

(a) f (x) ≥ 0 pour tout x réel.

(b) f est intégrable et P (a ≤ X ≤ b) =

ba

f (x)dx si a < b.

(c)

+∞−∞

f (x)dx = 1.

(d) F (x) = x

−∞

f (t)dt, pour tout x réel.

Exemple: Loi exponentielleSoit α > 0, une v.a. X est dite exponentielle de paramètre α si

F (x) =

1 − e−αx si x > 00 si x ≤ 0.

La fonction de densité est donnée par

f (x) =

αe−αx si x > 00 si x ≤ 0.

I.2.2 Espérance d’une variable aléatoire

Soit X une v.a. discrète prenant ses valeurs dans un ensemble D. La moyenne ou l’espé-

rance de X , notée E [X ], est le nombre

E [X ] =x∈D

xP (X = x)

S. SAADI 6

5/14/2018 cours_processus_Sa3di - slidepdf.com

http://slidepdf.com/reader/full/coursprocessussa3di 7/37

CHAPITRE I RAPPELS

Exemple: Soit X une v.a. de Bernoulli de paramètre p (B(1,p)), alors

E [X ] = 0 × P (X = 0) + 1 × P (X = 1)= p

Si X est une v.a. continue de fonction densité f , on définie l’espérance de X par,

E [X ] =

+∞−∞

xf (x)dx

Exemple: Soit X une v.a. exponentielle de paramètre α. Alors

E [X ] =

+∞0

xαe−αxdx =1

α

I.2.3 Variance et covariance

Définition I.2.6 Soient X et Y deux v.a. On a

var(X ) = E ((X − E [X ])2) = E [X 2] − (E [X ])2 ≥ 0.

cov(X,Y ) = E ((X − E [X ])(Y − E [Y ])) = E (XY ) − E (X )E (Y ).

I.3 Indépendance

I.3.1 Indépendance d’évenements

Définition I.3.1 Deux événements A et B sont indépendants si

P (A ∩ B) = P (A)P (B).

Définition I.3.2 n événements A1,...,An sont indépendants ssi

P (i∈I

Ai) =i∈I

P (Ai), ∀I ⊂ 1,...,n.

Remarques I.3.3 1. Pour n > 2 , la condition P (A1 ∩ ... ∩ An) = P (A1)...P (An) ne

suffit pas.

2. L’indépendance de n événements est plus forte que l’indépendance deux à deux.

S. SAADI 7

5/14/2018 cours_processus_Sa3di - slidepdf.com

http://slidepdf.com/reader/full/coursprocessussa3di 8/37

CHAPITRE I RAPPELS

I.3.2 Indépendance de tribus

Définition I.3.4 Une famille (F 1,...,F n) de sous-tribu de F est indépendante si

P (A1 ∩ ... ∩ An) = P (A1)...P (An), ∀A1 ∈ F 1,...,An ∈ F n.

Proposition I.3.5 (σ(A1),...,σ(An)) est une famille de sous-tribus indépendantes ssi les évé-

nements (A1,...,An) sont indépendants.

I.3.3 Indépendance de variables aléatoires

Définition I.3.6 Une famille (X 1,...,X n) de v.a. est indépendante si la famille de sous-tribu

(σ(X 1),...,σ(X n)) est indépendante.

Proposition I.3.7 (X 1,...,X n) est une famille de v.a. indépendantes ssi les événements X 1 ≤x1 ,...,X n ≤ xn sont indépendants ∀x1,...,xn ∈ R

En particulier X ⊥ Y ssi P (X ≤ x,Y ≤ y) = P (X ≤ x)P (Y ≤ y), ∀x,y ∈ RProposition I.3.8 Soient c ∈ R et X , Y deux v.a. Si X ⊥ Y , alors

– E (XY ) = E (X )E (Y ) , on dit qu’elles sont décorrélées; la réciproque n’est pas vraie.

– var(cX + Y ) = c2var(X ) + var(Y )

Proposition I.3.9 Soient X , Y deux v.a. continues possédant une densité conjointe f X,Y (i.e.

P (X ≤ x,Y ≤ y) = x−∞

y−∞

f X,Y (u,v)dudv). Si X ⊥ Y alors

f X,Y (x,y) = f X(x)f Y (y), ∀x,y ∈ R.

I.4 Espérance conditionnelle

I.4.1 Conditionnement par rapport à un événement

Soit A,B∈ F

tel que P (B)= 0

P (A|B) =P (A ∩ B)

P (B)

Soit X une v.a. tel que E (|X |) < ∞,

E (X |B) =E (X 1B)

P (B), s i P (B) = 0

S. SAADI 8

5/14/2018 cours_processus_Sa3di - slidepdf.com

http://slidepdf.com/reader/full/coursprocessussa3di 9/37

CHAPITRE I RAPPELS

I.4.2 Conditionnement par rapport à une variable aléatoire discrète Y

Soit A ∈ F , P (A|Y ) = ϕ(Y ), où ϕ(y) = P (A|Y = y), y ∈ D.

Soit X une v.a., E (X |Y ) = ψ(Y ), où ψ(y) = E (X |Y = y), y ∈ D.

Remarque I.4.1 Il est important de voir que P (A|Y ) et E (X |Y ) sont des v.a.!

Exemple: Soient (X 1,X 2) deux jets de dés indépendants, E (X 1 + X 2|X 2) = ψ(X 2), où

ψ(y) = E (X 1 + X 2|X 2 = y) =E ((X 1 + X 2)1X2=y)

P (X 2 = y)

=E ((X 1 + y)1X2=y)

P (X 2 = y)=

E (X 1 + y)P (X 2 = y)

P (X 2 = y)= E (X 1) + y

Donc E (X 1 + X 2|X 2) = E (X 1) + X 2

I.4.3 Conditionnement par rapport à une v.a. Y continue

Si P (A|Y ) = ϕ(Y ), où ϕ(y) = P (A|Y = y)Problème: P (Y = y) = 0?Il vaut donc mieux généraliser la définition pour une tribu.

I.4.4 Conditionnement par rapport à une tribu GSoient (Ω,F ,P ) un espace de probabilité; X une v.a. F -mesurable telle que E (|X | < ∞)

et G une sous-tribu de F .Théorème I.4.2 Il existe une v.a. Z telle que E (|Z | < ∞) et

(i) Z est une v.a. G-mesurable.

(ii) E (XU ) = E (ZU ) , ∀ U v.a. G-mesurable et bornée.

Z est notée E (X |G) et est appelée l’espérance conditionnelle de X par rapport à G.

De plus, si Z 1 et Z 2 vérifient (i) et (ii), alors Z 1 = Z 2 p.s.

La condition (ii) est équivalente à la condition,(ii)’ E (X 1B) = E (Z 1B), ∀B ∈ GDéfinition I.4.3 – On définit la probabilité conditionnelle par rapport à une tribu par

P (A|G) = E (1A|G)

S. SAADI 9

5/14/2018 cours_processus_Sa3di - slidepdf.com

http://slidepdf.com/reader/full/coursprocessussa3di 10/37

CHAPITRE I RAPPELS

– Et on définit l’espérance conditionnelle par rapport à une v.a. par

E (X |Y ) = E (X |σ(Y ))

Proposition I.4.4 Soient X , Y deux v.a. continues possédant une densité conjointe f X,Y ,

alors

E (X |Y ) = ψ(Y ) p.s. où ψ(y) = E (X |Y = y) =1

f Y (y)

R

xf X,Y (x,y)dx

et f Y (y) =

R

f X,Y (x,y)dx.

Preuve: Soit B ∈ B(R),

E [X 1Y ∈B] =

x1y∈Bf X,Y (x,y)dxdy

=

x1y∈B

f X,Y (x,y)

f Y (y)f Y (y)dxdy

=

x

f X,Y (x,y)

f Y (y)dx

1y∈Bf Y (y)dy

=

ψ(y)1y∈Bf Y (y)dy = E [ψ(Y )1Y ∈B]

Propriétés: Soient f, g et h des fonctions mesurables.

P1 E [αX 1

+ βX 2|

Y ] = αE [X 1|

Y ] + βE [X 2|

Y ]

P2 Si X et Y sont deus v.a. indépendantes alors E [f (X )|Y ] = E [f (X )] .En particulier E [X |Y ] = E [X ]

P3 E [E [X |Y ]|Y ] = E [X |Y ]

P4 E [g(X )h(Y )|Y ] = h(Y )E [g(X )|Y ]

P5 E [E [f (X,Y )|Y ]] = E [f (X,Y )], c-à-d l’espérance de l’espérance conditionnelle estégale à l’espérance.

I.5 Convergences de suites de variables aléatoires

Soient (X n)n∈N une suite de v.a. et X une autre v.a., toutes définies sur (Ω,F ,P ). Il yaplusieurs façons de définir la convergence de la suite (X n)n∈N vers X ,

Convergence en probabilité

X n→P n→∞X si lim

n→∞P (ω ∈ Ω : |X n(ω) − X (ω)| > ε) = 0

S. SAADI 10

5/14/2018 cours_processus_Sa3di - slidepdf.com

http://slidepdf.com/reader/full/coursprocessussa3di 11/37

CHAPITRE I RAPPELS

Convergence presque sûr

X n

→n→∞X p.s. si P (

ω

∈Ω : lim

n→∞

X n(ω) = X (ω)

) = 1.

Remarque I.5.1 Si X n→n→∞X p.s., alors X n→P n→∞X

Convergence en moyenne (ou convergence L1)

limn→∞

E (|X n − X |) = 0

Convergence en moyenne quadratique (ou convergence L2)

limn→∞

E (|X n − X |2) = 0

Remarque I.5.2 L’une ou l’autre de ces convergences implique la convergence en probabi-

lité.

Convergence en loi

Soient (X n)n une suite de v.a. (définies sur (Ω,F ,P )) et (F Xn) la suite des fonctions de

répartition correspondantes (F Xn(t) = P (X n ≤ t).) X n converge en loi vers X , on noteX n⇒n→∞X , si lim

n→∞F Xn

(t) = F X(t), ∀t ∈ R point de continuité de F X .

Théorèmes limites

Théorème I.5.3 (Loi des grands nombres)

Soient (X n)n une suite de variables aléatoires indépendantes et identiquement distribuées

(i.i.d.), d’espérance finie m, alors la v.a. S n =n

i=1

X i vérifie,

S n

n⇒ m

Théorème I.5.4 (Théorème de la limite centrale)

Soient (X n)n une suite de variables aléatoires indépendantes et identiquement distribuées

(i.i.d.), d’espérance finie m, et variance finie σ2 alors la v.a. S n =n

i=1

X i satisfait,

S n − nm√nσ

⇒ Z

où Z suit une loi normale centrée réduite, N (0,1).

S. SAADI 11

5/14/2018 cours_processus_Sa3di - slidepdf.com

http://slidepdf.com/reader/full/coursprocessussa3di 12/37

Chapitre II

Généralités

Les cours de probabilités s’intéressent essentiellement à l’étude d’une variable alèatoire,notament sa loi, son espérance, sa variance, ou plus généralement à l’étude d’un couple ouvecteur aléatoire.Ce cours s’intéresse à l’étude des familles de variables aléatoires indexées par un paramétrediscret ou continu.

II.1 Processus stochastique

Définition II.1.1 Soit I un ensemble de réels (I = N,Z,R ,ou R+

). Un processus stochas-tique est une famille (X t,t ∈ I ) de variables aléatoires (v.a.) définies sur un même espace

de probabilité (Ω,F ,P ) et à valeurs dans un espace d’états (E,E ).

On peut également le voir comme une fonction aléatoire:

X : Ω → fonctions de I dans E ω → t → X t(ω)

– I est l’ensemble des indices. Souvent t représente le temps. Si I est à valeurs discrèteson parle de processus à temps discret et si l’ensemble des valeurs de I est continue, onparle de processus à temps continu. Ainsi si

– I = N: instants successifs à partir d’un instant initial t0.– I = Z: instants successifs avant et après un instant t0.– I = R ou R+: idem mais en temps continu.

– L’ensemble des états du processus peut être continu ou discret.– La notion de processus stochastique élargit la notion de variable aléatoire. Une réali-

sation d’un processus stochastique est appelée trajectoire.

12

5/14/2018 cours_processus_Sa3di - slidepdf.com

http://slidepdf.com/reader/full/coursprocessussa3di 13/37

CHAPITRE II GÉNÉRALITÉS

C’est donc la fonction t → X t(ω), ω fixé dans Ω.

Exemples:

1. Jeu de "pile ou face". Aprés chaque lancer le joueur gagne 1dh s’il obtient "pile" etperd 1dh s’il obtient "face". La variable X n représentant sa fortune après n tirage estun processus appelé marche aléatoire ou processus de Bernouilli.(I = N et E = Z)C’est un processus à temps discret et à espace d’états discret.

2. le cours d’une action cotée en bourse au jour le jour.

– X t: valeur de l’action à la date t.– E = R

+.

– I = jour de cotationC’est un processus à temps discret et espace d’états continu.

3. Mouvement Brownien: Une particule suspendue dans un liquide homogène, subit deschocs de la part des molécules de ce liquide d’où un mouvement aléatoire de la parti-cule.(X t)t∈R+ est le processus qui donne la position de la particule à l’instant t.

Pour caractériser une variable aléatoire X, il suffit de donner sa loi P (X ≤ x), ∀x ∈ E.

Question: Que faut-il pour caractériser un processus (X t,t ∈ I )?Réponse: Donner P (X t1 ≤ x1,X t2 ≤ x2,...,X tn ≤ xn), pour tout n ∈ N

∗, t1,t2,...,tn ∈ I ;x1,x2,...,xn

∈R.

Question: Mais a-t-on toujours besoin de toutes ces informations pour caractériser un pro-cessus?

II.2 Classification de Processus stochastiques

II.2.1 Processus à accroissements indépendants et stationnaires

Définition II.2.1 (a) (X t)t∈I est dit à accroissements indépendants si

∀t1 < t2 < ... < tn ,

les variables aléatoires X t2 − X t1 ,..., X tn − X tn−1 sont indépendantes.(b) Si la loi de X t − X s ne dépend que de t − s et non de t et de s , on dira que (X t)t∈I est

à accroissements stationnaires.

Un processus stochastique vérifiant (a) et (b) est dit processus à accroissements indépen-

dants et stationnaires.

S. SAADI 13

5/14/2018 cours_processus_Sa3di - slidepdf.com

http://slidepdf.com/reader/full/coursprocessussa3di 14/37

CHAPITRE II GÉNÉRALITÉS

Pour un tel processus:

– Connaitre la loi de X t − X 0, ∀t > 0, ainsi que celle de X 0 suffit à caractériser entière-ment le processus.

– E (X t) = m0 + m1t, avec m0 = E (X 0) et m1 = E (X 1) − m0.

En effet: Soit f (t) = E (X t − X 0), alors

f (t + s) = E (X t+s − X 0)= E (X t+s − X s) + E (X s − X 0)= E (X t − X 0) + E (X s − X 0)= f (t) + f (s)

Donc f est linéaire et par suite elle s’écrit f (t) = αt, i.e E (X t) = αt + E (X 0).– var(X t) = σ2

0 + σ21t, avec σ2

0 = var(X 0) et σ21 = var(X 1) − σ2

0 .

II.2.2 Processus stationnaires

– On dira que le processus (X t)t∈I est stationnaire si ∀n ∈ N, ∀t1,t2,...,tn ∈ I et ∀h ∈ I

(X t1,X t2,...,X tn) et (X t1+h,X t2+h,...,X tn+h) ont même loi.

– On dira que X t est à covariance stationnaire si cov(X t,X t+h) ne dépend que de h.

– Un processus (X t)t∈I stationnaire et tel que E (X 2t ) existe, est à covariance station-naire.

S. SAADI 14

5/14/2018 cours_processus_Sa3di - slidepdf.com

http://slidepdf.com/reader/full/coursprocessussa3di 15/37

Chapitre III

Processus de Poisson

Dans ce chapitre nous allons étudier un processus défini sur R+, à valeurs dans un en-semble fini ou dénombrable E, qui est constant entre ses sauts qui se produisent à des instantsaléatoires.Ce processus modélise des répartitions aléatoires de point sur R+, qui peuvent correspondreà des instants de collision de particules, mais aussi à des instants d’arrivée de clients dansune file d’attente, d’appels à un central téléphonique.

III.1 Processus ponctuels et fonction de comptage

Un processus ponctuel sur R+, se décrit par la donnée d’une suite croissante de pointsaléatoires,

0 < T 1 < T 2 < ... < T n < ... dans R+

qui sont des v.a. définies sur un espace de probabilité (Ω,F ,P ). On suppose de plus queT n ∞, quand n → ∞.

On posera:S 1 = T 1S 2 = T 2 − T 1...

......

S n = T n − T n−1...

......

Les v.a. T n sont les instants où se produisent un événement, les S n sont les délais ou lestemps d’attente entre deux événements successifs.

On définit la f.a. de comptage N t,t ≥ 0 du processus ponctuel T n,n ∈ N de la fa-

15

5/14/2018 cours_processus_Sa3di - slidepdf.com

http://slidepdf.com/reader/full/coursprocessussa3di 16/37

CHAPITRE III PROCESSUS DE POISSON

çon suivante:N t = supn,T n ≤ t

=

j≥1

1T j≤t

N t est donc le nombre d’événement qui se sont produits avant l’instant t.

Remarques III.1.1 1. Notons que N 0 = 0 , puisque T 1 > 0. Et pour tout t > 0 , N t < ∞ puisque T n ∞ , quand n → ∞.

2. Pour 0 ≤ s < t , N t − N s est le nombre d’événements qui se sont produits dans

l’intervalle de temps ]s,t].

Une trajectoire du processus N t,t ≥ 0 est une fonction en escalier, croissante, de sauts 1et continue à droite.

Notons que la donnée de N t,t ≥ 0 est équivalente à celle de la suite T n,n ∈ N,et que l’on a les relations:

N t ≥ n = T n ≤ tN t = n = T n ≤ t < T n+1N s < n ≤ N t = s < T n ≤ t

III.2 Processus de poisson

Définition III.2.1 On dit que le processus ponctuel T n,n ∈ N ou sa f.a. de comptage

N t,t ≥ 0 est un processus de Poisson si N t,t ≥ 0 est un processus stochastique à

accroissements indépendants et stationnaires. i.e. si

(a) ∀t0 < t1 < ... < tn dans R+ , les accroissements N tj − N tj−1; 1 ≤ j ≤ n sont des v.a.

indépendantes.

(b) Pour 0 ≤ s < t , la loi de N t − N s ne dépend de s et t que par la différence t-s.

Le nom "Processus de Poisson" est justifié par la

Proposition III.2.2 Soit

N t,t

≥ 0la f.a.de comptage d’un processus de Poisson. Il existe

λ > 0 tel que pour tout 0 ≤ s < t , la loi de N t − N s est la loi de Poisson de paramètre

λ(t − s) , i.e.

P (N t − N s = k) = e−λ(t−s) [λ(t − s)]k

k!, k ∈ N.

Remarque III.2.3 Ce paramètre λ est appelé l’intensité du processus de Poisson N t. Il

est égal au nombre moyen d’événement qui se produisent pendant un intervalle de temps de

S. SAADI 16

5/14/2018 cours_processus_Sa3di - slidepdf.com

http://slidepdf.com/reader/full/coursprocessussa3di 17/37

CHAPITRE III PROCESSUS DE POISSON

longeur unité, i.e.

E [N t+1 − N t] = λ.

Remarque III.2.4 On a

P (N t+h − N t = 0) = 1 − λh + o(h)P (N t+h − N t = 1) = λh + o(h)P (N t+h − N t ≥ 2) = o(h)

Donc à des probabilités petites devant h près, N t+h − N t est une v.a. de Bernouilli prenant

la valeur 0 avec la probabilité 1 − λh et la valeur 1 avec la probabilité λh Cette propriété

jointe à l’indépendance des accroissements et à la formule

N t+s − N t =n

j=1

[N t+ jh − N t+( j−1)h] avec h =s

n

entraine que N t+s − N t suit approximativement une loi binomiale de paramètres (n,λsn ). Or

quand n → ∞ , cette loi converge vers la loi de Poisson de paramètre λs

Corollaire III.2.5 Soit N t,t ≥ 0 la f.a. de comptage d’un processus de Poisson. Il existe

λ > 0 tel que pour tout t ≥ 0 , la loi de N t est la loi de Poisson de paramètre λt , i.e.

P (N t = k) = e−λt [λt]k

k!, k ∈ N.

Corollaire III.2.6 Soit N t,t ≥ 0 la f.a. de comptage d’un processus de Poisson d’intensité

λ. Alors pour tout s,t ≥ 0, et k ∈ N ,

P [N t+s − N t = k|N u; u ≤ t] = P [N t+s − N t = k]

=e−λs(λs)k

k!

III.3 Les temps d’arrivées

Le corollaire III.5.2 reste valable si on remplace le temps arbitraire t par un temps d’arrivéeT n, soit,

P [N T n+s − N T n = 0|N u; u ≤ T n] = e−λs,

où N u; u ≤ T n est l’histoire du procesus jusqu’à l’instant T n. Remarquons que,

N T n+s − N T n = 0 = T n+1 − T n > set que l’histoire contenue dans N u; u ≤ T n est la même que celle contenue dans T 1,...,T n.Nous avons donc le résultat remarquable,

S. SAADI 17

5/14/2018 cours_processus_Sa3di - slidepdf.com

http://slidepdf.com/reader/full/coursprocessussa3di 18/37

CHAPITRE III PROCESSUS DE POISSON

Proposition III.3.1 Pour tout n ≥ 0 ,

P [T n+1 − T n ≤ t|T 0,...,T n] = 1 − e−λt

(On convient que T 0 = 0). En d’autres termes,

les v.a. S n = T n+1 − T n : délais ou temps d’attente entre deux événements successifs sont

indépendants et identiquement distribuées (i.i.d), de distribution commune la distribution

exponentielle de paramètre λ.

Dans certaines situation il est plus pratique de travailler avec les temps d’arrivées au lieu duprocessus de comptage. D’où l’intérêt du théorème suivant,

Théorème III.3.2 Un processus ponctuel T n,n ∈ N ou sa fonction aléatoire de comptage

N t,t ≥ 0 est un processus de Poisson d’intensité λ si et seulement si les interévénementsT 1,T 2 − T 1,... sont des v.a. indépendantes et identiquement distribuées de distribution expo-

nentielle de paramètre λ.

Proposition III.3.3 Pour tout n ∈ N∗ ,

P [T n ≤ t] = 1 −n−1k=0

e−λt(λt)k

k!

III.4 Superposition de Processus de Poisson

Considérons les arrivées à un carrefour par deux voies différentes.Soient (T n)n≥0 la suite des arrivées par la première voie et (T n )n≥0 la suite des arrivées parla seconde voie.On ordonne les (T n)n≥0 et (T n )n≥0 pour obtenir la suite (T n)n≥0. Soit,

N t = N t + N t

(N t)t≥0 est un processus de poisson d’intensité λ et (N t )t≥0 est un processus de poissond’intensité λ,

alors (N t)t≥0 est un processus de poisson d’intensité λ = λ

+ λ

.

III.5 Décomposition d’un processus de poisson

Soit (N t)t≥0 un processus de poisson d’intensité λ et soit (X n)n≥0 un processus de Ber-noulli (P (X n = 1) = p) indépendant de N t.

S. SAADI 18

5/14/2018 cours_processus_Sa3di - slidepdf.com

http://slidepdf.com/reader/full/coursprocessussa3di 19/37

CHAPITRE III PROCESSUS DE POISSON

A chaque arrivée on fait un tirage de bernoulli, l’arrivée va-t-il tourner à droite ou à gauche.Soit S n: le nombre de succés, S n = X 1 + X 2 + ... + X n.

Dans [0,t] on a N t arrivée donc S N t succés. On pose M t = S N t

Lt = N t − M t

Théorème III.5.1 Les processus M = (M t)t≥0 et L = (Lt)t≥0 sont des processus de pois-

son de taux respectifs λp et λq.

De plus M et L sont indépendant.

III.5.1 paradoxe de l’autobus

Soit (T n)n≥1 un processus de poisson de paramètre λ. Soit t ∈]0, + ∞[.On a N t = Sup

n,T n(ω)

≤t

.

Soit

V t = T N t+1 − tW t = t − T N t

Théorème III.5.2 – Les v.a. V t et W t sont indépendantes.

– La loi de W t est donnée par:

F W (v) =

1 si v ≥ t

1 − e−λv si v < t

S. SAADI 19

5/14/2018 cours_processus_Sa3di - slidepdf.com

http://slidepdf.com/reader/full/coursprocessussa3di 20/37

Chapitre IV

Chaînes de Markov

Connaissant le présent on peut oublier le passé pour prédire l’avenir.

IV.1 Définition et propriétés

Définition IV.1.1 Un processus stochastique (X n)n≥0 définie sur (Ω,F ,P ) à espaces d’état

E fini ou dénombrable et à espace de temps T = N , est une chaîne de Markov si:

P [X n+1 = j|X 0,X 1,...,X n] = P [X n+1 = j|X n], ∀ j ∈ E, ∀n ∈ NUne chaîne de Markov X est homogène si ces probabilités sont indépendantes de n, on note:

P [X n+1 = j|X n = i] = P (i,j)

qu’on appelle probabilité de transition.

c’est un processus qui "oublie" son histoire au fur et à mesure

Un critère simple qui permet souvent de vérifier qu’un processus est une chaîne de Markovest

Lemme IV.1.2 Soient E et F deux ensembles dénombrables, et f une application deN×E ×F dans E. Soit X 0,Y 1,Y 2,... des v.a. mutuellement indépendantes, X 0 à valeurs dans E et les

Y n à valeurs dans F, et (X n)n≥0 le processus à valeurs dans E défini par

X n+1 = f (n,X n,Y n+1), n ∈ N.

Alors (X n)n≥0 est une chaîne de Markov.

20

5/14/2018 cours_processus_Sa3di - slidepdf.com

http://slidepdf.com/reader/full/coursprocessussa3di 21/37

CHAPITRE IV CHAÎNES DE MARKOV

Exemple: File d’attente en temps discretOn considère une file d’attente qui se forme à un guichet. X n désigne le nombre de clientsdans la file en attente ou en train de se faire servire à l’instant n. Entre les instants n et n+1 ar-

rivent Y n+1 clients, et si X n > 0 partent Z n+1 clients. On suppose que X 0,Y 1,Z 1,Y 2,Z 2,...sontindépendantes, vérifiant 0 < P (Y n = 0) < 1, et les Z n vérifiant P (Z n = 1 ) = p =1 − P (Z n = 0). C’est à dire que

X n+1 = X n + Y n+1 − 1Xn>0Z n+1

Soit la matrice P = (P (i,j))i,j (éventuellement infinie). P est une matrice stochastique oumarkovienne i.e

P (i,j) ≥ 0, ∀i ∈ E et j∈E

P (i,j) = 1.

Théorème IV.1.3 Pour tout n,m ∈ N , m ≥ 1 , i0,i1,...,in ∈ E ,

P [X n+1 = i1,X n+2 = i2,...,X n+m = im|X n = i0] = P (i0,i1)P (i1,i2)...P (im−1,im)

Preuve:

P [X n+1 = i1,X n+2 = i2,...,X n+m = im|X n = i0] =P [X n+m = im|X n = i0,X n+1 = i1,...,X n+m−1 = im−1]P [X n+1 = i1,...,X n+m−1 = im−1|X n = i0]

Or

P [X n+m = im|X n = i0,X n+1 = i1,X n+2 = i2,...,X n+m−1 = im−1] = P [X n+m = im|X n+m−1 == P (im−1,im)

D’où le résultat par récurence.

Corollaire IV.1.4 Soit Π une loi sur E tel que P (X 0 = i) = Π(i) , Π est dite loi initiale,

alors∀

m∈N , m

≥ 1 , i

0,i1

,...,in ∈

E ,

P [X 0 = i0,X 1 = i1,...,X m = im] = Π(i0)P (i0,i1)P (i1,i2)...P (im−1,im)

La loi d’une chaîne de Markov est entièrement déterminée par la donnée d’une loi initialeΠ, qui est la loi de X 0, et de la matrice de transition de la chaîne.

S. SAADI 21

5/14/2018 cours_processus_Sa3di - slidepdf.com

http://slidepdf.com/reader/full/coursprocessussa3di 22/37

CHAPITRE IV CHAÎNES DE MARKOV

Remarque:

P [X n+2 = j|X n = i] =k

P [X n+2 = j,X n+1 = k,|X n = i]

=k

P [X n+2 = j|X n+1 = k,X n = i]P [X n+1 = k|X n = i]

=k

P (k,j)P (i,k)

= P 2(i,j)

Résultat qu’on généralise dans la

Proposition IV.1.5 ∀m ∈ N ,

P [X n+m = j|X n = i] = P m(i,j), ∀i,j ∈ E, n ∈ N

Equation de Chapman-Kolmogorov:Soit r, s, q, entiers tels que q = r + s, alors,

P q = P rP s

autrement ditP q(i,j) =

k∈E

P r(i,k)P s(k,j)

Théorème IV.1.6 Soit Π une loi sur (E,E ) et une matrice markovienne P = (P (i,j))i,j ,alors il existe une chaîne de Markov (X n)n≥0 de loi initiale Π et de matrice de transition P.

Exemple de chaîne de Markov: Marche aléatoire:

(Y n)n≥1 suite de v.a. i.i.d de loi F sur E dénombrable.

X n = Y 1 + Y 2 + ... + Y n

(X n)n≥1est une chaîne de markov.

P (X n+m − X n = k|X 1,X 2,...,X n) = P (Y n+1 + ... + Y n+m = k|Y 1,...,Y n)= P (Y n+1 + ... + Y n+m = k)= P (X n+m − X n = k)

On en déduit,

P (X n+1 = j|X n) =P (X n+1 = j,X n = i)

P (X n = i)

=P (X n+1 − X n = j − i,X n = i)

P (X n = i)

= P (Y n+1 = j − i)P (X n = i)

P (X n = i)= P (Y n+1 = j − i)

S. SAADI 22

5/14/2018 cours_processus_Sa3di - slidepdf.com

http://slidepdf.com/reader/full/coursprocessussa3di 23/37

CHAPITRE IV CHAÎNES DE MARKOV

IV.2 Proprièté forte de Markov

Soit

X n; n

∈N

une chaîne de Markov à valeurs dans E, définie sur l’espace de proba-

bilité (Ω,F ,P ).Pour tout n ≥ 0, Soit

F n = σ(X 0,...,X n)

C’est l’ensemble des évènements se produisant jusqu’à l’instant n.

Le théorème suivant est une conséquence directe de la définition des chaînes de Markov.On l’appelle parfois propriété de Markov faible.

Théorème IV.2.1 Pour tout A ∈ F n et pour tout p > 0 , i,i1,...,i p ∈ E ,

P (A ∩ X n+1 = i1,...,X n+ p = i p|X n = i) = P (A|X n = i)P (X 1 = i1,...,X p = i p|X 0 = i)

Le résultat précédent confirme que le passé et le futur sont conditionnellement indépendants,sachant la position de la chaîne à l’instant présent n.

La propriété de Markov forte permet d’établir ce résultat en remplaçant l’instant fixe n parun instant aléatoire vérifiant une certaine propriété.

IV.2.1 Temps d’arrêt

Définition IV.2.2 Une v.a. T à valeurs dans N∪+∞ est appelée un temps d’arrêt si pour

tout n ∈ N ,

T = n ∈ F n.

Cela signifie qu’en observant la chaîne jusqu’à l’instant n, on peut décider si T = n alieu ou non.

Exemples:

1. On définit la variable S x par:

S x = inf n ∈ N : X n = x,

avec la convention inf ∅ = +∞. S x représente le temps de premier passage à l’état x

de la chaîne. Alors il est clair que S x est un temps d’arrêt :

S x = n = X 0 = x ∩ ... ∩ X n−1 = x ∩ X n = x ∈ F n.

S. SAADI 23

5/14/2018 cours_processus_Sa3di - slidepdf.com

http://slidepdf.com/reader/full/coursprocessussa3di 24/37

CHAPITRE IV CHAÎNES DE MARKOV

Et plus généralement:2. ∀A ⊂ E , le temps d’entrée dans A,

T A

= inf

n∈N : X

n ∈A

est un temps d’arrêt.

3. On définit la variable T x par:

T x = inf n > S x : X n = x.

T x représente le temps du premier retour à l’état x de la chaîne. T x est un temps d’arrêt.4. Par contre, la variable Lx définie par:

Lx = supn ∈ N : X n = x.

qui représente le temps du dernier passage à l’état x de la chaîne, n’est pas un tempsd’arrêt.

On notera F T la tribu des événements "déterminés par X 0,...,X T ", définie comme la tribudes événements B ∈ F tels que ∀n ∈ N,

B ∩ T = n ∈ F n.

Proposition IV.2.3 1. T est un temps d’arrêt ⇔ T ≤ n ∈ F n pour tout n.

2. F T est une tribu.

Pour n

≤ ∞ ,

F T

∩ T = n

=

F n

∩ T = n

3. T constante égal à n ∈ N est un temps d’arrêt.

4. Si T 1 et T 2 sont deux temps d’arrêt alors,

– Sup(T 1,T 2) = T 1 ∨ T 2 et inf (T 1,T 2) = T 1 ∧ T 2 sont des temps d’arrêts.

– T 1 < T 2 et T 1 = T 2 sont dans F T 1 ∩ F T 2 .

– Pour T 1 ≤ T 2 , on a F T 1 ⊂ F T 2.

Remarque:T est F T -mesurable.En effet: T = n = Ω ∩ T = n ∈ F T .

IV.2.2 Propriété de Markov forte

Théorème IV.2.4 Soit X n : n ≥ 0 une chaîne de Markov, et T un temps d’arrêt. Alors

pour tout A ∈ F T , et pour tout p > 0, i,i1,...,i p ∈ E ,

P (A∩X T +1 = i1,...,X T + p = i p|X T = i,T < ∞) = P (A|X T = i,T < ∞)P (X 1 = i1,...,X p = i p

S. SAADI 24

5/14/2018 cours_processus_Sa3di - slidepdf.com

http://slidepdf.com/reader/full/coursprocessussa3di 25/37

CHAPITRE IV CHAÎNES DE MARKOV

IV.3 Classification des états

Beaucoup de chaînes ont la propriété suivante: la loi de X n tend vers une limite indépen-

dante de la loi initiale. Pour pouvoir les caractériser il faut commencer par différencier lesétats que la chaîne peut visiter une infinité de fois de ceux qui ne peuvent l’être qu’un nombrefini de fois.

IV.3.1 Etat récurrent et état transitoire

Soit (X n)n≥0 une chaîne de Markov tel que X 0 = j.On pose P j(A) = P [A|X 0 = j].

Définition IV.3.1 Soit (X n)n une chaîne de Markov partant de j ∈ E . L’état j est dit

1. Transitoire si P j[X n = j pour une infinité de valeurs de n] = 0.

oun≥1

P j(X n = j) < ∞

2. Récurrent si P j[X n = j pour une infinité de valeurs de n] = 1.

oun≥1

P j(X n = j) = +∞

Pour j

∈E on introduit T n la suite des instants successifs de retour en j définie par récurrence

pour n ≥ 1T 1 = inf n ≥ 1 : X n = j

T n+1 = inf n ≥ T n + 1 : X n = javec la convention inf ∅ = ∞T n est un temps d’arrêt.

Proposition IV.3.2 Soit X n une chaîne de Markov partant de j ∈ E . L’état j est

1. Transitoire si P j[T 1 < ∞] < 1.

2. Récurrent si P j[T 1 <

∞] = 1.

On définit le nombre de retour à l’état j:

N j =∞n=1

1Xn= j

Proposition IV.3.3 1. Si j est récurrent, alors P j(N j = +∞) = 1

S. SAADI 25

5/14/2018 cours_processus_Sa3di - slidepdf.com

http://slidepdf.com/reader/full/coursprocessussa3di 26/37

CHAPITRE IV CHAÎNES DE MARKOV

2. Si j est transitoire P j(N j = k) = (1 − π j)πk j , k ≥ 0 , avec π j = P j(T 1 < ∞).

Corollaire IV.3.4 L’état j est récurrent ssi

∞n=0

P n( j,j) = +∞

Remarque: Si j est transitoire

E j(N j) = π j(1 − π j)−1 < ∞Définition IV.3.5 Soit j un état récurrent, il est dit

1. Récurrent positif si E j[T 1] < ∞.

2. Récurrent nul si E j [T 1] = ∞.

Définition IV.3.6 Un état j est absorbant ssi P ( j,j) = 1 , on a alors P (i,j) = 0,∀

i= j.

Pour résumer

Il existe trois type d’état, transitoire: on n’y revient pas toujours; récurrent nul: on y revienttoujours au bout d’un temps moyen infini; ou récurrent positif: on y revient une infinité defois à intervalles de temps finis, en moyenne.

IV.3.2 Classes

Définition IV.3.7 Etant donnée une chaîne de Markov (X n)n∈N de distribution initiale Π et

de matrice de transition P, on dira que l’état j est accessible depuis l’état i, ou que i conduit à j s’il existe n ∈ N tel que P n(i,j) > 0. On notera i → j.

On dira que les états i et j communiquent , noté i ↔ j , si i → j et j → i.

La relation de communication (↔) entre deux états est réfléxive (par convention ∀i, P 0(i,i) =1), symétrique (par définition), et transitive, c’est donc une relation d’équivalence.il est donc possible de construire une partition des états d’une chaîne de Markov en classesd’équivalence telle que tous les états d’une classe communiquent entre eux et que deux étatsappartenant à deux classes différentes ne communiquent pas.

Théorème IV.3.8 Soit C

⊂E une classe d’équivalence pour la relation

↔. Alors tous les

états de C sont soit récurrents soit transitoires.

Définition IV.3.9 Une chaîne de Markov (X n)n∈N de distribution initiale Π et de matrice de

transition P, est dite irréductible si E est constitué d’une seule classe d’équivalence. Elle est

dite récurrente irréductible si de plus tous les états sont récurrents.

Proposition IV.3.10 Toute chaîne de Markov irréductible sur un espace fini E est irréduc-

tible.

S. SAADI 26

5/14/2018 cours_processus_Sa3di - slidepdf.com

http://slidepdf.com/reader/full/coursprocessussa3di 27/37

CHAPITRE IV CHAÎNES DE MARKOV

IV.3.3 Période

Définition IV.3.11 Soit j un état récurrent, on appelle période de j,noté d(j) le

pdcdn ≥ 1 : P n( j,j) > 0

Une autre manière équivalente de dire les choses est: d( j) est la période de j si

n = kd( j), k ∈ N ⇒ P n( j,j) > 0.

n = kd( j), k ∈ N ⇒ P n( j,j) = 0.

Proposition IV.3.12 Deux états j et k appartenant à la même classe de récurrence ont même

période.

Définition IV.3.13 l’état j est dit apériodique Si d( j) = 1.

La période étant une propriété de classe, on parlera de classe périodiques / apériodiques et dechaînes de Markov irréductibles périodiques / apériodiques selon les propriétés de leur états.

IV.4 Comportement asymptotique

IV.4.1 Cas récurrent irréductible

Soit (X n) une chaîne de Markov irréductible récurrente. Nous allons commencer parétudier les excursions successives de la chaîne entre deux retours successifs à l’état j:

E k = (X T k ,X T k + 1,...,X T k+1); k ≥ 0

Ces excursions sont des suites aléatoires de longueur aléatoire finie ≥ 2, formées d’états deE distincts de j, sauf le premier et le dernier qui sont égaux à j. Notons U l’ensemble desvaleurs des excurssions E k,k ≥ 0, c’est un ensemble dénombrable.

Proposition IV.4.1 Sous P j la suite (E 0,E 1,...) des excurssions est i.i.d., c’est-à-dire pour

tout k > 0 , u0,...,uk

∈U ,

P j(E 0 = u0,...,E k = uk) =k

l=0

P j(E l = ul).

Définition IV.4.2 Soit P une matrice markovienne. On dit que µ mesure sur E est invariante

par P si

µP = µ.

S. SAADI 27

5/14/2018 cours_processus_Sa3di - slidepdf.com

http://slidepdf.com/reader/full/coursprocessussa3di 28/37

CHAPITRE IV CHAÎNES DE MARKOV

Une mesure de Probabilité µ est invariante par une chaîne de Markov (µ,P ) ssi µ est la loide X n pour tout n ∈ N.

Remarque: Soit π une probabilité invariante, c’est-à-dire

i= j

π(i)P (i,j) = π( j)(1 − P (i,i)),

soitP (X n = j,X n+1 = j) = P (X n = j,X n+1 = j),

ce qui signifie que le nommbre moyen de sorties de l’état j entre les instants n et n+1 est égalau nombre moyen d’entrées à l’état j entre n et n+1.

Théorème IV.4.3 Soit (X n)n≥0 une chaîne de Markov de matrice de transition P récur-

rente irréductible. Alors il existe une mesure strictement positive invariante µ , unique à une

constante multiplicative près.

Théorème IV.4.4 Soit (X n)n≥0 une chaîne de Markov récurrente irréductible. Les asser-

tions suivantes sont équivalentes:

(i) J est récurrent positif.

(ii) Tous les états sont récurrents positifs.

(iii) Il existe une probabilité invariante donnée par:

π( j) =1

m j, ∀ j ∈ E avec m j = E j [T 1]

Par conséquent, on distingue dans le cas récurrent irréductible, deux cas de figures:

– Le cas récurrent positif: tous les états sont récurrents positifs et il existe une uniqueprobabilité invariante.

– Le cas récurrent nul: tous les états sont récurrents nuls et toutes les mesures invariantessont de masse infinie (

i

π(i) = +∞)

Il est clair que si E est fini, il n’existe pas d’état récurrent nul, tout état récurrent est récur-rent positif.

On est en mesure maintenant d’établir le théorème ergodique.

Théorème IV.4.5 (Théorème ergodique) Soit (X n)n∈N une chaîne de Markov irréductible

récurrente positive, de probabilité invariante π. Soit f : E → R une fonction bornée. Alors

1

n

nk=1

f (X k) → p.s.n→+∞

j∈E

π( j)f ( j)

S. SAADI 28

5/14/2018 cours_processus_Sa3di - slidepdf.com

http://slidepdf.com/reader/full/coursprocessussa3di 29/37

CHAPITRE IV CHAÎNES DE MARKOV

Ce théorème est une généralisation de la loi des grands nombres au cas où la suite (X n)n∈Nn’est pas indépendante. En effet on peut écrire la relation précédente comme suit:

1

n

nk=1

f (X k) → p.s.n→+∞ E π[f (X )]

ou X est de loi π: la probabilité invariante.Une conséquence du théorème ergodique est la suivante: si on munit la chaîne de la loiinitiale π, alors la suite est identiquement distribuée et la moyenne empirique converge versl’espérance.

IV.4.2 Chaînes apériodiques

Le théorème ergodique nous assure en particulier que si (X n)n∈N une chaîne de Markovirréductible récurrente positive, alors:

1

n

nk=1

1X k = j → p.s.n→+∞ π( j), ∀ j ∈ E

Puisque la convergence p.s. entraîne la convergence en moyenne, en prenant l’espérance sousP i, on a

1

n

nk=1

P k(i,j) →n→+∞ π( j), ∀i,j ∈ E

On voit que les moyennes de Césaro des (P k(i,j)) convergent. On peut se demander si dansle cas irréductible récurrent positif, on a:

P n(i,j) →n→+∞ π( j), ∀i,j ∈ E ?

La réponse est non! Soit par exemple une chaine de Markov de matrice de transition P

vérifiant P 2k = I et P 2k+1 = P.

Théorème IV.4.6 Soit (X n)n∈N une chaîne de Markov de matrice de transition P , irréduc-

tible récurrente positive et apériodique , de probabilité invariante π. Alors

P (X n = j) →n→+∞ π( j), ∀ j ∈ E

Soit

(µP n) j →n→+∞ π( j), ∀i,j ∈ E,

pour toute loi initiale µ. En particulier

P n(i,j) →n→+∞ π( j), ∀i,j ∈ E.

S. SAADI 29

5/14/2018 cours_processus_Sa3di - slidepdf.com

http://slidepdf.com/reader/full/coursprocessussa3di 30/37

Chapitre V

Processus Markovien de saut

Dans ce chapitre, nous allons présenter l’essentiel de la théorie des processus de Markoven temps continu, à valeurs dans un ensemble fini ou dénombrable E.

V.1 Définition et Propriétés

Le but de ce chapitre est d’étudier les processus de Markov à valeurs dans un espace d’étatE fini ou dénombrable. On supposera que les trajectoires de nos processus n’ont que desdiscontinuités de première espèce (des sauts), et pour fixer les idées que les trajectoires sont

continues à droite et pourvues de limite à gauche en tout point. Les trajectoires d’un tel pro-cessus X t,t ≥ 0 sont nécessairement constantes entre ses sauts, lesquels se produisent àdes instants aléatoires T 1(ω); T 2(ω); ...; T n(ω); .... La différence avec le processus de Pois-son est que, connaissant la position avant le saut, la position après le saut est aléatoire.

Définition V.1.1 – Un processus stochastique X t,t ≥ 0 est un processus de Markov

à espace d’états E dénombrable si, ∀t,s ≥ 0 et j ∈ E ,

P [X t+s = j|X u,u ≤ t] = P [X t+s = j|X t]

– Si de plus

P [X t+s = j|X t]ne dépend que de s, le processus de Markov est dit homogène.

On n’étudiera dans la suite que des processus markoviens homogènes. On utilisera la nota-tion:

P [X t+s = j|X t = i] = P s(i,j)

30

5/14/2018 cours_processus_Sa3di - slidepdf.com

http://slidepdf.com/reader/full/coursprocessussa3di 31/37

CHAPITRE V PROCESSUS DE MARKOV

où pour tout t > 0, P t est une matrice markovienne sur E × E , appelée matrice de transitiondans le temps t.Propriétés:

1. P t(i,j) ≥ 0.

2. j∈E

P t(i,j) = 1.

3. limt→0

P t(i,j) =

1 si i = j

0 si i = j

Théorème V.1.2 Soit X t,t ≥ 0 un processus Markovien de saut, de loi initiale µ et de

matrices de transition P t,t > 0. Pour tout n ∈ N , 0 < t1 < ... < tn , la loi du vecteur

aléatoire (X 0,X t1,...,X tn) est donnée pour tout i0,i1,...,in ∈ E par:

P (X 0 = i0,X t1 = i1,...,X tn = in) = µ(i0)P t1(i0,i1)P t2−t1(i1,i2)...P tn−tn−1(in−1,in)

Par conséquent, si µt est la loi de la v.a. X t , on a pour tout t > 0

µt = µP t

i.e. µt( j) =i∈E

µ(i)P t(i,j).

D’autre part, les matrices de transition P t,t > 0 vérifient la relation de semi-groupe

(Equation de Chapman-Kolmogorov):

P t+s = P tP s

ou encore

P t+s(i,j) =k∈E

P t(i,k)P s(k,j).

Exemple 1: Un processus de Poisson N t,t ≥ 0 d’intensité λ est un processus de Markovà valeurs dans N, de matrices de transition:

P t(i,j) =

e−λt (λt) j−i

( j − i)!si j ≥ i

0 sinon

Exemple 2: La file d’attente M/M/1.les arrivées forment un processus de poisson.Les temps de services sont i.i.d. de distribution exponentielle. Un seul serveur.X t: longeur de la file à l’instant t c’est-à-dire le nombre de clients en attente + celui qui esten train d’être servi.(X t)t≥0 est un processus de Markov.

S. SAADI 31

5/14/2018 cours_processus_Sa3di - slidepdf.com

http://slidepdf.com/reader/full/coursprocessussa3di 32/37

CHAPITRE V PROCESSUS DE MARKOV

V.2 propriété de Markov forte

V.2.1 Temps d’arrêt

Soit la filtration F = (F t) ou F t = σ(X s,s ≤ t) et F ∞ = σ(∪F t)Définition V.2.1 1. Un temps d’arrêt T est une v.a. vérifiant

∀t ≥ 0, T ≤ t ∈ F t.2. Si T est un t.a., la tribu F T des événements antérieur à T est

F T = A ∈ F ∞,A∩ ∈ T ≤ t ∈ F t ∀t ≥ 0

Propriétés:1. Une constante est un temps d’arrêt.2. T 1,T 2 deux temps d’arrêt, alors sup(T 1,T 2) et inf(T 1,T 2) sont des temps d’arrêt.3. Les événements T 1 < T 2, T 1 ≤ T 2, T 1 = T 2 ∈ F T 1 ∩ F T 2.

4. T 1 ≤ T 2 implique F T 1 ⊂ F T 2.

Théorème V.2.2 Propriété de Markov forte.

Soit X t : t ≥ 0 un processus de Markov, et T un temps d’arrêt. Alors pour tout A ∈ F T ,et pour tout p > 0, , 0 < t1 < t2 < ... < t p , i,i1,...,i p ∈ E ,

P (

A∩

X T +t1 =

i1

,...,X T +tp =

i p|

X T =

i,T <∞) =

P (

A|X

T =i,T <

∞)P i(

X t1 =

i1

,...,X tp =

V.3 Générateur infinitésimal

La propriété de semi-groupe fait que P t est connu pour tout t dès qu’il est connu pour t

petit.

V.3.1 Temps passé dans un état

On suppose que X t = i

Soit W t: le temps qui sépare t de l’instant où le processus X quitte l’état i.W t = inf s ≥ 0,X t+s = X t.

Théorème V.3.1 Soit i ∈ E , t ≥ 0 , il existe λ(i) ≥ 0 tel que,

P [W t > u|X t = i] = e−λ(i)u

S. SAADI 32

5/14/2018 cours_processus_Sa3di - slidepdf.com

http://slidepdf.com/reader/full/coursprocessussa3di 33/37

CHAPITRE V PROCESSUS DE MARKOV

– Si λ(i) = ∞, dés que le processus il entre dans l’état i il en sort, i est appelé état

instantané.

– Si λ(i) = 0, quand on entre dans l’état i, on en sort plus, l’état est dit absorbant.

– Si 0 < λ(i) < ∞, l’état est dit stable.

V.3.2 Chaîne de Markov incluse

Soit X t,t ≥ 0 un processus de Markov dont les temps de saut T 1,T 2,...,T n,... vérifient lacondition T n(ω) → +∞ p.s quand n → ∞ (tous les états sont stables).

T n+1 = T n + W T n

Soit la suite Z n, n

∈N définie par:

Z n = X T n, avec T 0 = 0

Les Z n sont les états visités successivement.Z n = i veut dire X t = i pour t ∈ [T n,T n+1[: intervalle de séjour dans l’état i.

Théorème V.3.2 Pour tout n ∈ N , j ∈ E , et u ∈ R+ , on a

P [Z n+1 = j,T n+1 − T n > u|Z 0,...,Z n,T 0,...,T n] = Q(i,j)e−λ(i)u, si Z n = i

où Q est une matrice stochastique, tal que Q(i,i) = 0.

Corollaire V.3.3 La suite (Z n)n∈N des états successifs est une chaîne de Markov appelée la

chaîne incluse , de matrice de transition Q.

Corollaire V.3.4 Pour tout n ∈ N , i0,i1,...,in ∈ E et u1,u2,...,un ∈ R , on a

P [T 1 − T 0 > u1,...,T n − T n−1 > un|Z 0 = i0,...,Z n = in] = e−λ(i0)u1...e−λ(in−1)un

Les inter-transitions sont indépendantes et exponentiellement distribuées, elles ne dépendentque de l’état visité et sont indépendante de l’état prochain.Remarque: Si il existe W T m p.s infini, c’est-à dire T m+1 infini, on pose Z 0 = X 0 et

Z n+1 =

X T n+1 si T n+1 < ∞X n si T n+1 = ∞

– Si un état i est absorbant pour le processus, alors i est absorbant pour la chaîne incluse.

– Si i est stable, Q(i,i) = 0.

S. SAADI 33

5/14/2018 cours_processus_Sa3di - slidepdf.com

http://slidepdf.com/reader/full/coursprocessussa3di 34/37

CHAPITRE V PROCESSUS DE MARKOV

V.3.3 Equations de Kolmogorov

Proposition V.3.5 Pour tout i,j ∈ E et tout t ∈ R+ ,

P t(i,j) = e−λ(i)tI (i,j) +

t0

λ(i)e−λ(i)sk∈E

Q(i,k)P t−s(k,j)ds

Théorème V.3.6 Pour tout i,j ∈ E , la fonction t → P t(i,j) est continument dérivable et sa

dérivée à l’instant t = 0 est donnée par

A(i,j) =

−λ(i) si j = i

λ(i)Q(i,j) si j = i

A est appelé générateur infinitésimal du processus X

Corollaire V.3.7 (i) P t, t ≥ 0 est l’unique solution de l’équation de Kolmogorov "rétro-

grade" (Backward):dP t

dt= AP t, P 0 = I

(ii) P t, t ≥ 0 est l’unique solution de l’équation de Kolmogorov "progressive" (farward):

dP t

dt= P tA, P 0 = I

– Si la fonction de transition P t est connue, alors A dérivée de P t en 0 est connu et par

conséquent λ(i) et Q sont connus, en effet: λ(i) = −A(i,i)

– Si λ(i) = 0, Q(i,j) =A(i,j)

λ(i)si i = j et Q(i,i) = 0.

– Si λ(i) = 0, Q(i,j) = 0 si i = j et Q(i,i) = 1.

– Si A est connu, alors P t solution de l’équation de Kolmogorov est le semi-groupeengendré par A:

P t = etA =∞n=0

tn

n!An

Remarques:

1. Pour tout i ∈ E , −λ(i) + j=i

λ(i)Q(i,j) = 0

2. Au voisinage de t=0 on a:

P t(i,j) = I (i,j) + tA(i,j) + o(t).

S. SAADI 34

5/14/2018 cours_processus_Sa3di - slidepdf.com

http://slidepdf.com/reader/full/coursprocessussa3di 35/37

CHAPITRE V PROCESSUS DE MARKOV

V.4 Mesures invariantes et Théorèmes limites

V.4.1 Classification des états

Dans ce qui suit, on désignera comme dans le cas du temps discret par P i la loi condition-nelle de X t,t ≥ 0, sachant que X 0 = i. Les classes d’équivalence du processus de markovsont celles de la chaîne incluse.

Définition V.4.1 Le processus de Markov X t,t ≥ 0 est irréductible si la chaîne incluse

Z n,n ∈ N l’est.

Notons que dés que X t,t ≥ 0 est irréductible,

P t(i,j) > 0, ∀i,j ∈ E, t > 0.

En effet par l’irréductibilité de la chaîne incluse, ∀i,j ∈ E , il existe n ∈ N, i0 = i,i1,...,in = j

tel que Q(i0,i1)...Q(in−1,in) > 0, où Q est la matrice de transition de la chaîne incluse. Ainsi

on a A(i0,i1)...A(in−1,in) > 0, or A(i,j) = limh→0+

P h(i,j)

hil s’en suit que

∀t > 0, P t(i,j) > P t/n(i,i1)...P t/n(in−1,j) > 0

Définition V.4.2 Un état j ∈ E est dit récurrent (resp. transitoire) pour le processus (X t)t≥0s’il est récurrent (resp. transitoire) pour la chaîne incluse.

En particulier dans le cas irréductible, tous les états sont soit récurrents soit transitoires.

V.4.2 Le cas irréductible récurrent

Comme dans le cas discret, on a l’existence d’une unique mesure invariante dans le casrécurrent irréductible.

Théorème V.4.3 Soit un processus Markovien de sauts X t,t ≥ 0 , irréductible récurrent,

de générateur infinitésimal A et de semi-groupe de transition

P t,t

≥0

. Alors il existe une

unique mesure strictement positive µ , à une constante multiplicative près, qui vérifie,

µA = 0

Et qui est invariante pour le semi-groupe de transition, c’est-à-dire,

µP t = µ, ∀t ≥ 0

S. SAADI 35

5/14/2018 cours_processus_Sa3di - slidepdf.com

http://slidepdf.com/reader/full/coursprocessussa3di 36/37

CHAPITRE V PROCESSUS DE MARKOV

V.4.3 Théorèmes limites

On se place dans le cas d’un processus X t,t ≥ 0 irréductible récurrent. On va prouver

dans cette section l’existence d’une unique probabilité invariante dans le cas particulier ré-current positif. Pour distinguer entre récurrence nulle et récurrence positive, on ne peut pasregarder seulement les propriétés de la chaîne incluse. On verra qu’il existe des processusmarkoviens de sauts récurrents nuls dont la chaîne incluse est récurrente positive, et inverse-ment. Pour définir la récurrence positive ou nulle. Définissons l’instant du premier retour àl’état j comme:

R j = inf t ≥ T 1 : X t = j

Définition V.4.4 L’état j est dit récurrent positif s’il est récurrent et si E j[R j] < ∞ , récur-

rent nul s’il est récurrent et si E j[R j] = +∞.

A nouveau, comme dans le cas discret, si j ∈ E est récurrent positif, alors tous les états sontrécurrents positifs et le processus est dit récurrent positif. Dans ce cas, il existe une uniqueprobabilité invariante.

Théorème V.4.5 Soit (X t)t≥0 un processus Markovien de sauts récurrent, irréductible. Les

assertions suivantes sont équivalentes:

(i) j est récurrent positif.

(ii) Tous les états sont récurrents positifs.

(iii) Il existe une unique probabilité invariante donnée par:

π( j) = 1λ( j)m j

, ∀ j ∈ E avec m j = E j[R j]

Remarque: Une mesure invariante π pour le processus markovien (X t)t≥0 vérifie πA = 0.Cela implique que πΛ est invariante pour Q, matrice de transition de la chaîne incluse.Il estalors facile de choisir Λ la matrice diagonale des temps de séjours en chaque état telle que(X t)t≥0 est récurrent nul et Q récurrente positive, et vice versa. Il faut pour cela jouer sur lestemps de séjours en chaque point.

Dans le cas d’un processus irréductible récurrent positif, on peut énoncer le théorème

ergodique de la manière suivante.

Théorème V.4.6 Soit (X t)t≥0 un processus markovien de sauts irréductible récurrent posi-

tif. On note π sa probabilité invariante. Alors, pour f : E → R bornée, on a :

1

t

t0

f (X s)ds →i∈E

f (i)π(i), p.s. quand t → ∞

S. SAADI 36

5/14/2018 cours_processus_Sa3di - slidepdf.com

http://slidepdf.com/reader/full/coursprocessussa3di 37/37

CHAPITRE V PROCESSUS DE MARKOV

Dans le cas du temps continu, la convergence de la loi de X t vers la probabilité inva-riante quand t → ∞ est vraie dans le cas irréductible et récurrent positif, sans hypothèsesupplémentaire.

Théorème V.4.7 Soit (X t)t≥0 un processus markovien de sauts irréductible récurrent posi-

tif, et π son unique probabilité invariante. Alors pour toute probabilité µ sur E, on a, ∀ j ∈ E ,

(µP t)( j) →t→∞ π( j)

limt→∞

P j [X t = j] =1

λ( j)E j(R j)

Notons que si la probabilité invariante π est la loi de X 0, le processus (X t)t≥0 est station-

naire au sens où pour tout n ∈ N, 0 ≤ t1 < ... < tn, la loi du vecteur (X t1+s,...,X tn+s) nedépend pas de s.

Remarque: L’équation πA = 0 s’écrit ∀ j ∈ E,

j=i

π( j)A( j,i) = π(i) j=i

A(i,j).

Le membre de gauche de cette égalité s’interprète comme le flux entrant dans l’état i àl’équilibre en provenance des différents états, le membre de droite comme le flux sortant dei à l’équilibre, vers les divers états.l’équation πA = 0 dit donc qu’à l’équilibre, les nombres moyens par unité de temps dedéparts et d’arrivées à chaque état sont égaux.

S. SAADI 37